Künstliche Intelligenz wird immer vielseitiger – von der Routenplanung bis zum Übersetzen von Texten ist sie längst zum Standard-Tool geworden. Doch es genügt nicht, dass die künstliche Intelligenz sinnvolle Ergebnisse liefert; immer wichtiger wird es auch, dass sie rechtliche, ethische und soziale Normen einhält. Aber wie lassen sich einer Maschine solche Normen beibringen?

An der TU Wien wurde nun ein neuer Ansatz dafür entwickelt. Durch eine Kombination von Machine Learning und Logik kann man autonome Agenten trainieren, die sich an vordefinierte Normen halten. Man kann sogar eine Rangordnung dieser Normen erstellen – also manche Normen als wichtiger einstufen als andere. Bei der IJCAI, einer der weltweit wichtigsten Fachkonferenzen der AI-Forschung, die dieses Jahr in Montreal (Kanada) stattfand, wurde diese Arbeit mit dem „Distinguished Paper Award“ ausgezeichnet.

Versuch und Irrtum

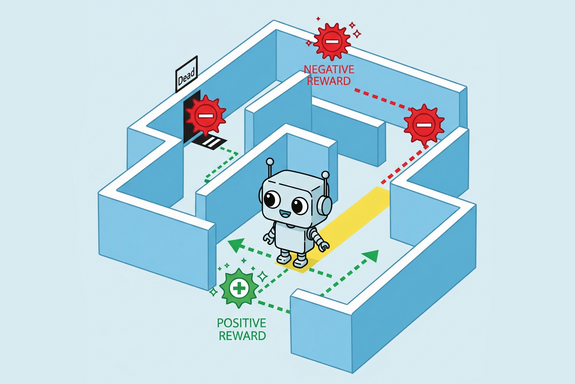

Wenn einer künstlichen Intelligenz eine neue Fähigkeit beigebracht wird, funktioniert das manchmal ein bisschen so, als würde man einem Tier neue Tricks zeigen: Belohnung, wenn die Aufgabe korrekt erledigt wurde, Bestrafung, wenn die Antwort falsch war. Die künstliche Intelligenz probiert unterschiedliche Verhaltensweisen aus und lernt durch Versuch und Irrtum, wie sie am besten ihre Belohnung maximieren kann. Diese Methode wird „Reinforcement Learning“ genannt und spielt in der AI-Forschung eine wichtige Rolle.

„Man könnte versuchen, einer AI bestimmte Regeln beizubringen, indem man sie für das Befolgen von Normen belohnt. Diese Technik funktioniert gut bei Sicherheitsvorgaben“, sagt Prof. Agata Ciabattoni vom Institut für Logic und Computation der TU Wien. „Aber bei bedingten Normen (‚tue A, wenn Bedingung B gilt‘) klappt das nicht. Wenn der Agent einen Weg findet, Belohnungen zu erhalten, könnte er absichtlich seine eigentliche Aufgabe verzögern, um mehr Zeit für einfache Zusatzpunkte zu haben.“

Normen als logische Formeln

Das Team der TU Wien wählte einen grundlegend anderen Weg, inspiriert von klassischen philosophischen Arbeiten: Normen werden weiterhin als logische Formeln dargestellt, aber der Agent wird bestraft, wenn er sie nicht einhält. So wird etwa „du darfst das Tempolimit nicht überschreiten“ übersetzt in „wenn du das Tempolimit überschreitest, erhältst du eine Strafe von X“. Am wichtigsten dabei: Jede Norm wird als eigenständiges Ziel behandelt.

„Der künstliche Agent bekommt ein Ziel, das er verfolgen soll – zum Beispiel die beste Route zu einer Liste von Destinationen zu finden. Gleichzeitig definieren wir zusätzliche Regeln und Normen, die er dabei einhalten muss“, erklärt Emery Neufeld, Erstautor des Papers. „Dass jede Norm als separates Ziel behandelt wird, erlaubt es uns, algorithmisch zu berechnen, welche Gewichtung diesen Zielen jeweils zugewiesen werden muss, um ein gutes Gesamtergebnis zu erreichen.“

Mit dieser Technik wird es möglich, auch komplizierte Regelwerke zu formulieren – etwa Normen, die nur unter bestimmten Bedingungen gelten, oder Normen, die von der Verletzung anderer Normen abhängen.

Flexible Normen

„Das Tolle daran ist, dass man bei einer Änderung der Normen das Training nicht wieder von vorne beginnen muss“, sagt Agata Ciabattoni. „Wir haben ein System, das lernt, Normen zu befolgen – aber wir können nachträglich diese Normen immer noch anpassen oder ihre relative Wichtigkeit ändern, indem wir zum Beispiel eine bestimmte Regel für wichtiger erklären als eine andere.“

In ihrem Paper konnte Ciabattoni mit ihrem Team zeigen, dass diese Technik erlaubt, eine vielfältige Palette von Normen vorzugeben, während die künstliche Intelligenz ihr Ziel verfolgt. Die Arbeit wurde auf der internationalen Konferenz IJCAI präsentiert und dort als eine der bedeutendsten Arbeiten des Jahres mit einem „Distinguished Paper Award“ ausgezeichnet – sie gehört damit zu den besten 0,05 % aller eingereichten Beiträge weltweit.

Originalpublikation

Die Originalpublikation wurde bei der AI-Konferenz IJCAI 2025 in Montreal, öffnet eine externe URL in einem neuen Fenster präsentiert:

E.A. Neufeld, A. Ciabattoni and R.F. Tulcan; Combining MORL with Restraining bolts to Learn Normative Behaviour, IJCAI 2025.

Frei zugängliche Version: https://ijcai-preprints.s3.us-west-1.amazonaws.com/2025/6660.pdf, öffnet eine externe URL in einem neuen Fenster

Rückfragehinweis

Prof. Agata Ciabattoni

Institut für Logic and Computation

Technische Universität Wien

+43 1 58801 18545

agata.ciabattoni@tuwien.ac.at

Aussender:

Dr. Florian Aigner

Kommunikation

Technische Universität Wien

+43 664 60588 4127

florian.aigner@tuwien.ac.at